Veille SEO 2022, semaine 15

Nous sommes la 15ème semaine de l'année…

...et cette semaine, sans que je comprenne vraiment pourquoi, j'ai dû me faufiler entre des tonnes d'articles qui expliquaient comment et pourquoi Google avait lancé de grands travaux dans le Google Plex, qui consistaient à poncer les sols. J'ai vraiment du mal avec cette attitude un peu fan-boy : si on est là pour faire ranker des sites, Google devrait être autant un allié qu'un ennemi.

Bonne lecture, et n'oubliez pas de vous amuser !

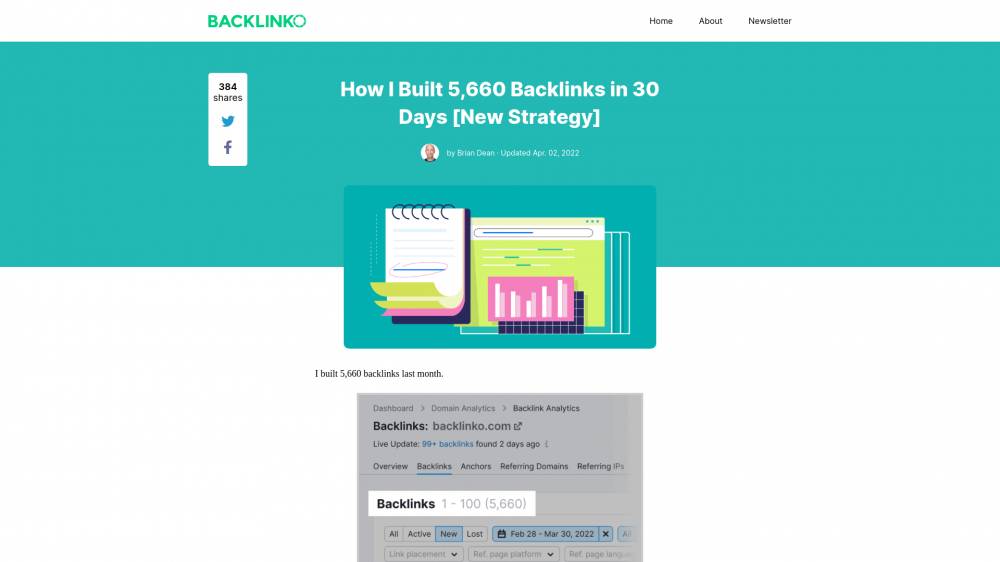

Il a gagné 6 000 backlinks en 30 jours

Chez Backlinko, Brian Dean nous explique comment il a gratté 6 000 backlinks en un mois, grâce au "reverse outreach".

Il s'agit de créer des contenus dont on SAIT qu'ils attireront les personnes les plus à même de nous faire un lien quand ils citeront leur source : les journalistes.

Brian a créé pour eux un article qui compile des statistiques à propos de TikTok. Et ça a bien marché : un an après sa publication, la page a accumulé quasiment un million de backlinks à elle seule, depuis des spots très visibles.

Alors, bien sûr, ça marche si on passe un temps dingue sur la création du contenu (qui n'est pas toujours orienté vers votre cible directe), et les résultats sont aléatoires, mais le "reverse outreach" est une technique assez maline qui mérite qu'on y réfléchisse.

Gros biais possible: "Backlinko" est déjà une marque établie. Ça sera sûrement plus compliqué avec votre nom de domaine tout neuf. Par exemple, l'article de Brian se positionnait 2ème sur "tiktok users" juste après avoir été publié.

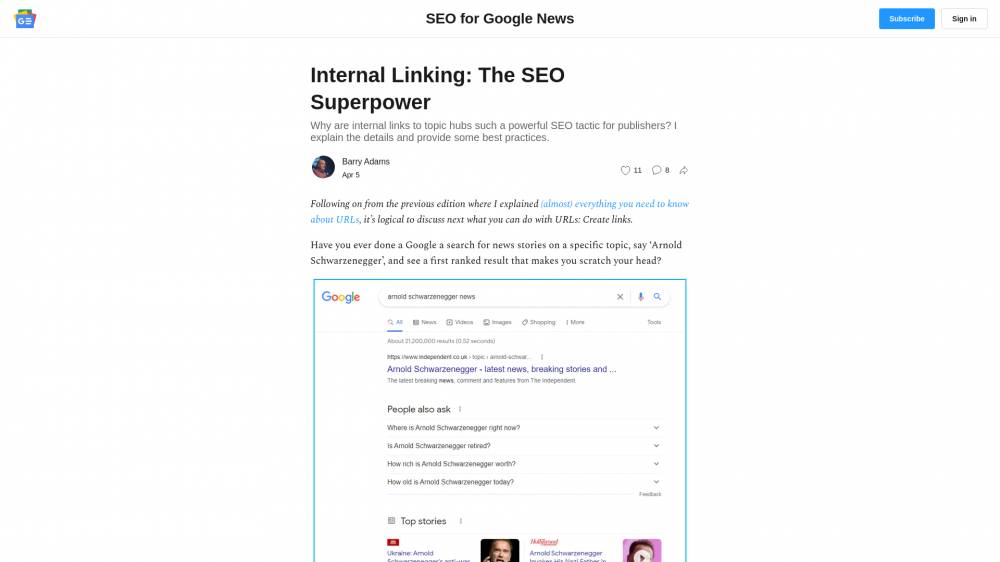

Liens internes vers des pages Hub

Barry Adams, consultant SEO spécialisé Google News, a remarqué que de nombreuses SERPs liées à l'actualité renvoyaient vers des "topic pages" (les pages de tag sous Wordpress, pour faire simple).

Ces pages collectent tous les contenus d'un site qui concernent une entité précise, et reçoivent des liens depuis tous les textes du site qui mentionnent cette entité.

Elles doivent être travaillées avec une attention toute particulière, être exhaustives, éviter la cannibalisation (c'est la situation qui se produit quand plusieurs pages d'un même site entrent en compétition pour le même mot-clé).

Ensuite, il semble logique que Google les mette en avant, puisqu'elles mâchent le travail de compréhension de l'intention de recherche, en couvrant "tout ce qu'il faut savoir" sur un thème particulier : en proposant ces pages, le moteur s'affranchit du devoir de savoir exactement ce que cherche l'internaute. Pratique pour les requêtes larges !

Pourquoi les gens croient aux mythes SEO

Danny Goodwin essaye de comprendre pourquoi autant de gens croient aux "mythes du SEO".

Sans entrer dans le détail des mythes en question, il enfile une casquette de sociologue pour entrer dans la tête des gens qui croient dur comme fer tout comprendre au SEO (avec une vision biaisée ou carrément fausse), et y explorer les mécanismes qui sous-tendent ce phénomène.

Surtout, fort de ces constats, il propose des pistes pour sortir du conflit : comment expliquer à votre interlocuteur qu'il a tort, sans le braquer ?

Le contenu généré par IA est contraire aux guidelines

Encore une partie de "Jacques a dit" avec John Mueller, search advocate chez Google.

Cette fois, John (il faut vraiment que je lui trouve un petit surnom) a décrété que les contenus générés par une intelligence artificielle sont contraires aux recommandations de Google : ces contenus sont considérés comme générés automatiquement, ce qui peut mener à une pénalité manuelle.

Le mot est lâché : si on vous attrape, on vous punit.

Cependant, Google reconnaît aussi qu'il ne peut pas, en l'état, détecter automatiquement ces contenus. C'est logique, puisque la méthode qui les produit est justement de simuler des textes écrits à la main, par analyse statistique (je simplifie, hein, ne m'en voulez pas).

John prédit un jeu du chat et de la souris entre Google et les webmasters, qui perfectionneront leurs techniques jusqu'à ce que le moteur arrive à régler le problème "de manière large" (via un algorithme). En attendant, c'est la webspam team qui va devoir pénaliser les sites manuellement, un par un.

Il faut aussi distinguer un contenu de type "100% IA" où on a laissé la main à un algorithme pour qu'il écrive ce qu'il veut, et un contenu où une IA a été utilisée comme "aide à la rédaction".

Le débat est lancé à l'heure où les outils comme Jasper (qui utilise le GPT-3 de OpenAI) ou YourTextGuru (avec leur SEO-TXL) se lancent massivement dans l'aide à la rédaction.

Si ces outils sont utilisés pour ce qu'ils sont (des assistants), et non pour rédiger de pleines pages qu'aucune main humaine ne viendra valider, je ne vois ni comment, ni même pourquoi, Google ferait le moindre effort pour endiguer cette vague. L'important, c'est que la qualité de sortie soit au rendez-vous pour que l'internaute reparte de votre site satisfait de sa visite.

Guide du SEO on-page pour 2022

Kristen McCormick s'est penchée sur ce qui faisait le succès d'une page dans les SERPs (hormis ses backlinks) en 2022.

Elle en a tiré une liste, un peu basique mais très utile, de bonnes pratiques. On va parler aussi bien de la structure (titres, intertitres) que des images, des liens internes, etc.

Kristen propose aussi plusieurs outils qui permettent d'évaluer la qualité perçue d'un site, et même un template Google Sheets qui peut servir de checklist quand vous voulez vous assurer qu'une page passe tous les tests de qualité que lui fera subir le moteur.